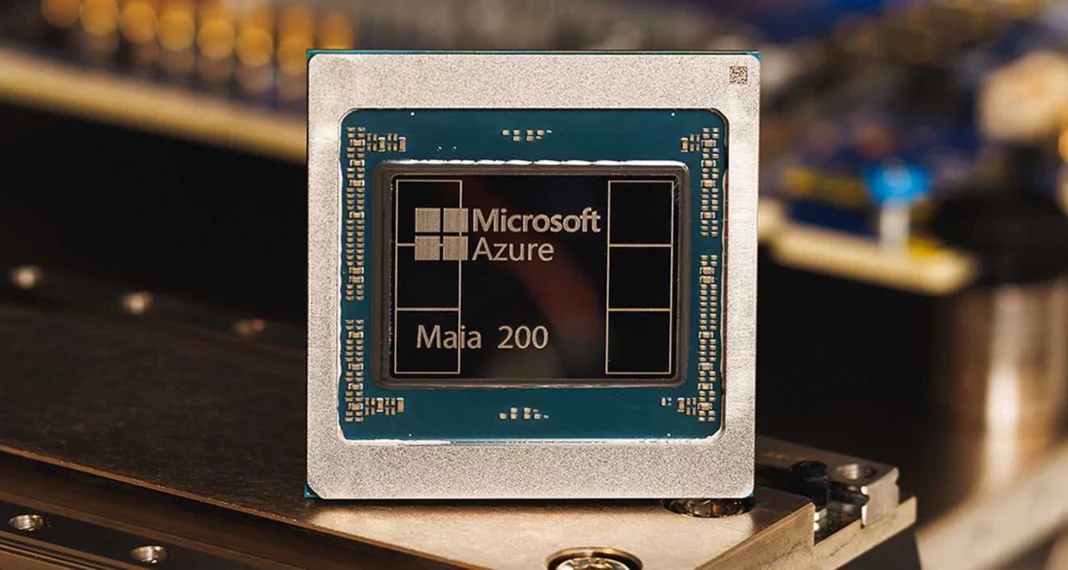

Microsoft a officiellement présenté la Maia 200, sa puce d’intelligence artificielle de deuxième génération, marquant une étape majeure dans la course technologique pour réduire la dépendance au matériel Nvidia. Cette annonce intervient alors que les géants du cloud multiplient les initiatives de puces personnalisées pour gagner en indépendance et en performance.

Une nouvelle puce IA pensée pour l’inférence très rapide

La Maia 200 entre en service cette semaine dans un centre de données situé dans l’Iowa, avec un second déploiement prévu en Arizona, selon des informations obtenues auprès de Reuters. Conçue spécifiquement pour les charges de travail d’inférence IA, Microsoft affirme que la Maia 200 offre jusqu’à trois fois les performances FP4 du processeur Trainium de troisième génération d’Amazon, ainsi que des configurations TPU d’Alphabet.

Cette montée en puissance promet d’accélérer considérablement les applications d’IA en production, des assistants virtuels aux systèmes de recommandation en passant par les modèles de langage.

Concurrencer Nvidia aussi sur le plan logiciel

Microsoft ne se limite pas au matériel. L’entreprise s’attaque également à l’un des points forts historiques de Nvidia : l’écosystème logiciel CUDA, largement utilisé par les développeurs IA. Pour relever ce défi, Microsoft proposera Triton, un outil de programmation open source développé avec des contributions significatives d’OpenAI.

Triton permet à des chercheurs sans expertise CUDA d’écrire du code GPU optimisé, avec des performances proches de celles obtenues par des programmeurs experts. Cette stratégie vise à réduire les coûts et les barrières de migration, souvent cités comme dissuasifs pour quitter l’écosystème Nvidia.

Conception et fabrication de pointe

La Maia 200 est fabriquée par Taiwan Semiconductor Manufacturing Co (TSMC) en utilisant un procédé de gravure 3 nanomètres. Elle intègre également des mémoire à large bande passante, optimisées pour les applications IA exigeantes.

Même si la technologie sous-jacente est légèrement plus ancienne que celle des puces « Vera Rubin » récemment annoncées par Nvidia, la Maia 200 se positionne comme une solution hautement compétitive pour les datacenters et les charges de travail intensives.

Une tendance industrielle forte

Le lancement de la Maia 200 s’inscrit dans une tendance plus large du marché, où les grands fournisseurs de services cloud cherchent à concevoir leurs propres puces IA. Nvidia reste dominant, avec environ 85 % du marché des accélérateurs IA, mais la dynamique évolue rapidement.

Des acteurs comme Google travaillent à attirer des clients jusqu’ici fidèles à Nvidia, tandis que Microsoft intègre des concepts innovants tels qu’une grande quantité de SRAM rapide, bénéfique pour les systèmes IA traitant de nombreuses requêtes utilisateur. Cette approche rappelle celle de sociétés comme Cerebras Systems, qui a signé un contrat de plusieurs milliards de dollars avec OpenAI, ou Groq, dont la technologie a été licenciée à Nvidia dans un accord majeur.

Une deuxième génération attendue et améliorée

La Maia 200 succède à la Maia 100, l’accélérateur IA sur mesure lancé par Microsoft fin 2023. Le développement de cette deuxième génération a connu des retards, notamment en raison de modifications de conception initiées par OpenAI et de mouvements de personnel, repoussant la production de masse à 2026.

Avec la Maia 200, Microsoft renforce sa stratégie autour des technologies IA, combinant matériel performant et logiciels open source pour offrir une alternative crédible aux solutions dominantes, tout en optimisant l’efficacité et la flexibilité pour les développeurs et les entreprises.